Microsoft a annoncé lundi avoir pris des mesures pour corriger une erreur de sécurité flagrante qui a conduit à l’exposition de 38 téraoctets de données privées.

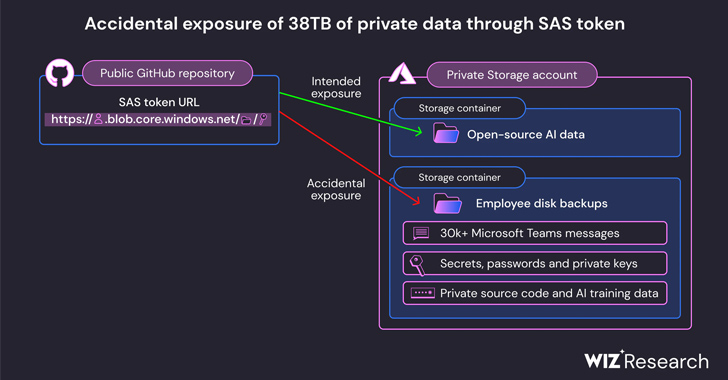

La fuite a été découverte sur le référentiel AI GitHub de l’entreprise et aurait été rendue publique par inadvertance lors de la publication d’un ensemble de données de formation open source, a déclaré Wiz. Il comprenait également une sauvegarde sur disque des postes de travail de deux anciens employés contenant des secrets, des clés, des mots de passe et plus de 30 000 messages internes des équipes.

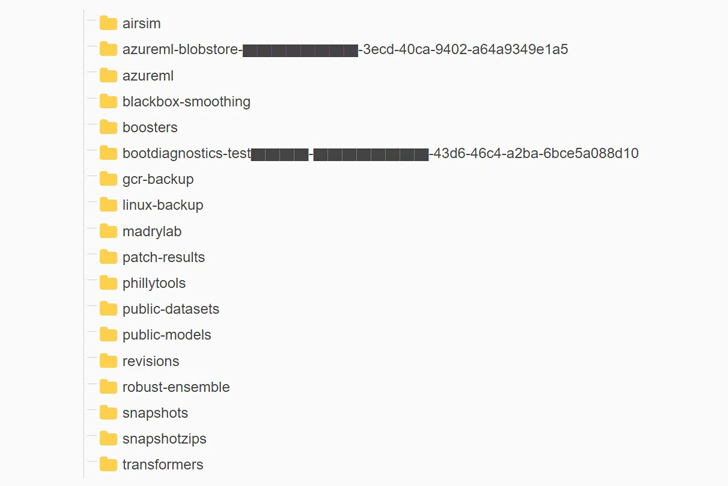

Le référentiel, nommé « robust-models-transfer » n’est plus accessible. Avant son retrait, il présentait du code source et des modèles d’apprentissage automatique relatifs à un document de recherche de 2020 intitulé « Les modèles ImageNet robustes de manière contradictoire transfèrent-ils mieux ?

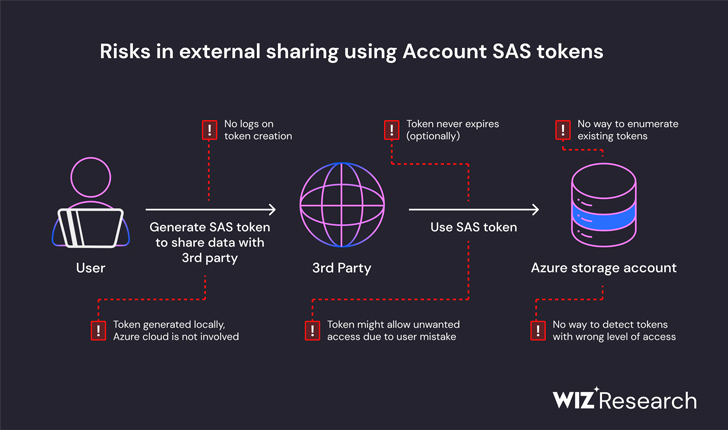

« Cette exposition est le résultat d’un jeton SAS trop permissif, une fonctionnalité Azure qui permet aux utilisateurs de partager des données d’une manière à la fois difficile à suivre et difficile à révoquer », a déclaré Wiz dans un rapport. Le problème a été signalé à Microsoft le 22 juin 2023.

Plus précisément, le fichier README.md du référentiel demandait aux développeurs de télécharger les modèles à partir d’une URL de stockage Azure qui accordait également accidentellement l’accès à l’intégralité du compte de stockage, exposant ainsi des données privées supplémentaires.

« En plus de la portée d’accès trop permissive, le jeton a également été mal configuré pour permettre des autorisations de « contrôle total » au lieu de lecture seule », ont déclaré les chercheurs de Wiz Hillai Ben-Sasson et Ronny Greenberg. « Cela signifie que non seulement un attaquant pourrait voir tous les fichiers du compte de stockage, mais il pourrait également supprimer et écraser les fichiers existants. »

En réponse à ces conclusions, Microsoft a déclaré que son enquête n’avait trouvé aucune preuve d’exposition non autorisée des données des clients et qu’« aucun autre service interne n’avait été mis en danger en raison de ce problème ». Il a pareillement souligné que les clients n’avaient aucune mesure à prendre de leur part.

Les fabricants de Windows ont en outre noté qu’il avait révoqué le jeton SAS et bloqué tout accès externe au compte de stockage. Le problème a été résolu deux jours après la divulgation responsable.

Pour atténuer ces risques à l’avenir, la société a étendu son service d’analyse secrète pour inclure tout jeton SAS susceptible d’avoir des expirations ou des privilèges trop permissifs. Il a déclaré avoir pareillement identifié un bug dans son système d’analyse qui signalait l’URL SAS spécifique dans le référentiel comme un faux positif.

« En raison du manque de sécurité et de gouvernance des jetons Account SAS, ils devraient être considérés comme aussi sensibles que la clé du compte elle-même », ont déclaré les chercheurs. « Par conséquent, il est fortement recommandé d’éviter d’utiliser le compte SAS pour le partage externe. Les erreurs de création de jetons peuvent facilement passer inaperçues et exposer des données sensibles. »

Ce n’est pas la première fois que des comptes de stockage Azure mal configurés sont révélés. En juillet 2022, JUMPSEC Labs a mis en évidence un scénario dans lequel un acteur malveillant pourrait profiter de tels comptes pour accéder à un environnement sur site d’entreprise.

Ce développement constitue la dernière erreur de sécurité de Microsoft et survient près de deux semaines après que la société a révélé que des pirates informatiques basés en Chine étaient capables d’infiltrer les systèmes de l’entreprise et de voler une clé de signature très sensible en compromettant le compte d’entreprise d’un ingénieur et en accédant probablement à un vidage sur incident de Microsoft. Le système de signature des consommateurs.

« L’IA ouvre un énorme potentiel aux entreprises technologiques. Cependant, alors que les scientifiques et les ingénieurs des données se précipitent pour mettre de nouvelles solutions d’IA en production, les quantités massives de données qu’ils traitent nécessitent des contrôles et des garanties de sécurité supplémentaires », a déclaré Ami Luttwak, CTO et co-fondateur de Wiz. une déclaration.

« Cette technologie émergente nécessite de vastes ensembles de données sur lesquelles s’entraîner. Alors que de nombreuses équipes de développement doivent manipuler d’énormes quantités de données, les partager avec leurs pairs ou collaborer sur des projets publics open source, des cas comme celui de Microsoft sont de plus en plus difficiles à surveiller et à éviter. «

Article traduit.

Source : https://thehackernews.com/2023/09/microsoft-ai-researchers-accidentally.html?m=1

Aucune réponse